大家做运维的,一定都经历过惊心动魄的故障处理吧,从半夜被告警叫醒,到紧急排查、恢复服务,再到复盘会上分析原因,这一套流程几乎成了我们的职业标配。最麻烦最令人头疼的,绝对是事后还要赶工写事故报告了,明明处理故障时思路清晰,可一到写报告,就不知道该从哪儿下手。

事故报告不是简单的“故障记录”,也不是为了应付上级的“交差作业”。它的真正价值,在于帮助我们从每一次故障中提炼出教训,避免同样的问题再次发生。今天我们聊聊IT事故报告的核心要素及一些注意事项,最后附赠5个IT界最典型,最常见的IT报告模板,希望可以帮到大家。

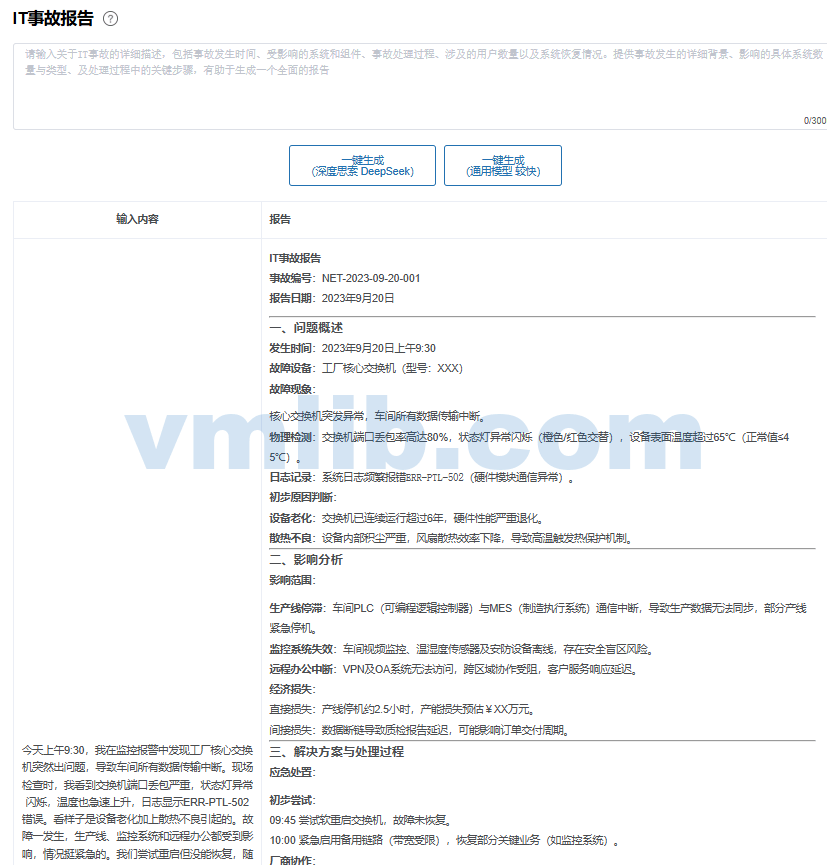

想快速生成专业规范的IT事故报告?

免费试试我们的AI工具!输入大概信息即可一键生成,省时省力!→ IT事故报告生成📄

IT事故报告6个必备要素

IT事故报告的价值,不在于罗列技术细节,而在于构建系统性认知。一次服务器卡机或数据泄露,背后往往是技术漏洞、流程缺陷与人为失误的交织。真正有效的报告其实解剖为三个维度:事实还原(时间线)、因果追溯(根因分析)、未来防御(行动计划):

- 明确的事故概述:包括事故类型(如系统中断、数据泄露)、发生时间、影响范围(用户、业务、时长)及严重等级(如P0-P3)。

- 详细的时间线:从故障发生、检测、响应到恢复的全流程记录,精确到分钟,体现处理时效性。

- 根因分析:区分直接原因(如代码缺陷)与深层原因(如测试流程缺失),避免仅描述表象。

- 解决措施:分“紧急修复”与“长期改进”两步,需具体说明技术方案和责任人。

- 量化影响:数据丢失量、宕机时长、财务损失、客户投诉量等,用于评估事故后果。

- 后续行动计划:明确预防措施、完成时间及验收标准,确保闭环管理。

IT事故报告的5大注意事项

撰写IT事故报告时,技术细节的堆砌常让人陷入“专业主义陷阱”,就是工程师看得懂,管理者却一头雾水;数据齐全,却因敏感信息泄露埋下合规风险。下面是5条关键注意事项,大家可以参考下:

- 及时性与客观性:报告需在事故解决后24-48小时内完成,避免主观猜测,用数据支撑结论。

- 语言简洁:技术细节需清晰但不过度冗长,关键信息用表格或流程图辅助说明。

- 权限与合规:敏感信息(如客户数据、内部架构)需脱敏,并标注访问权限和保密要求。

- 多方沟通记录:附上内部团队协作记录、外部用户通知及监管报备文件,留存证据。

- 复盘与共享:通过案例复盘会更新应急预案,并将报告归档为团队知识库参考资料

想快速生成专业规范的IT事故报告?

免费试试我们的AI工具!输入大概信息即可一键生成,省时省力!→ IT事故报告生成📄

5个最典型最常见的IT报告模板

以下是5个典型的IT事故报告模板,涵盖常见场景(系统中断、安全漏洞、数据丢失等),可根据实际需求调整内容:

模板1:系统/服务中断事故报告

IT事故报告

系统/服务名称:用户中心服务

中断时间(开始-结束):2024-XX-XX 08:00 – 2024-XX-XX 10:00(持续2小时)

1. 事故概述

- 影响范围:

- 用户数量:约5000+用户无法正常登录及访问个人中心功能。

- 业务功能:用户登录、身份验证、个人资料查询服务中断。

- 地域:华东地区业务受显著影响,其他地区部分功能响应延迟。

- 事故等级:P1(核心业务功能中断,影响范围广)。

2. 事故时间线

| 时间 | 事件描述 |

|---|---|

| 08:00 | 监控触发服务响应超时报警,错误率飙升至50%。 |

| 08:15 | 运维团队介入,初步排查网络及服务器状态。 |

| 09:30 | 确认原因为DB资源耗尽,无法处理高并发请求。 |

| 10:00 | 紧急扩容数据库并重启服务,功能逐步恢复。 |

3. 根本原因分析

- 直接原因:

数据库连接池最大线程数配置过低(原配置为100),在早高峰期间用户并发请求量激增至800+,导致连接池资源耗尽,后续请求被阻塞。 - 间接原因:

- 未进行压力测试:上线前未模拟高并发场景,未能识别连接池容量瓶颈。

- 监控告警阈值不合理:原有告警阈值未覆盖极端流量场景,导致未能提前预警。

4. 解决方案与恢复措施

- 紧急修复:

- 临时将数据库连接池容量从100扩容至500,快速恢复服务。

- 重启受影响服务器,释放异常占用的资源。

- 长期改进:

- 代码优化:重构数据库访问逻辑,减少长连接占用时间。

- 自动扩容机制:基于实时流量动态调整连接池容量,并设置弹性扩缩容策略。

- 完善监控:优化告警规则,增加连接池使用率、请求队列长度等关键指标监控。

5. 后续行动项

| 责任人 | 完成时间 | 任务 |

|---|---|---|

| 张三 | 2024-XX-XX | 更新压力测试方案,覆盖高并发及异常场景。 |

| 李四 | 2024-XX-XX | 修订数据库连接池配置标准,纳入运维手册。 |

| 王五 | 2024-XX-XX | 部署自动化监控工具,实现资源使用率实时预警。 |

报告提交人:运维部

提交日期:2024-XX-XX

审核人:技术总监(XXX)

备注:本次事故暴露了容量规划与测试流程的不足,后续将加强全链路压测及灾备演练,避免同类问题重复发生。

模板2:网络安全漏洞事故报告

1. 事故描述

漏洞类型:未授权访问

发现时间:2023年[具体日期]

影响系统/数据:用户个人信息数据库(包含姓名、邮箱、电话号码等敏感数据)

问题概述:

攻击者通过系统未配置鉴权机制的API接口,非法访问并获取了约500条用户记录。该漏洞暴露时间约为48小时,后被安全团队检测并拦截。

2. 漏洞分析

攻击路径:

- 攻击者利用未鉴权的

/api/v1/userdata接口,绕过身份认证直接发送数据请求。 - 接口未对请求来源进行IP限制或访问频率控制,导致攻击者通过脚本批量抓取数据。

影响分析:

- 数据泄露量:500条用户记录(含敏感信息),可能导致用户隐私泄露、钓鱼攻击等风险。

- 业务影响:用户信任度受损,潜在法律合规风险(如违反《个人信息保护法》)。

3. 应急响应

立即措施:

- 漏洞修复:关闭存在缺陷的API接口,重置所有相关访问密钥。

- 系统隔离:将受影响数据库与其他业务系统隔离,防止横向渗透。

- 日志审计:分析攻击路径,追溯异常请求来源及数据流向。

通知与协作:

- 24小时内向当地网信办及行业监管机构提交事件报告。

- 通过邮件及短信通知受影响用户,建议修改密码并警惕钓鱼风险。

4. 根本原因

- 开发缺陷:

- API接口开发阶段未实施输入验证及鉴权机制。

- 未遵循“最小权限原则”,开放了非必要的数据访问权限。

- 安全流程缺失:

- 未集成自动化安全扫描工具(如DAST/SAST),导致漏洞未在测试阶段发现。

- 缺乏代码审查流程,高风险代码直接上线。

5. 预防措施

技术改进:

- 代码审计:

- 强制实施代码安全审查流程,重点关注鉴权逻辑与输入验证。

- 引入静态代码分析工具(如SonarQube)与动态扫描工具(如Burp Suite)。

- 防御加固:

- 部署Web应用防火墙(WAF),配置规则拦截异常请求(如高频访问、非法参数)。

- 启用API接口的OAuth 2.0鉴权与访问频率限制。

管理优化:

- 组织全员网络安全培训,强化开发人员安全意识。

- 建立漏洞响应SOP(标准操作流程),明确事件上报与处理时限。

报告提交人:[安全团队负责人/职位]

提交日期:2023年[具体日期]

备注:本报告后续将提交至公司高层及外部审计部门备案,并作为未来安全改进的基线参考。

模板3:数据丢失/损坏事故报告

一、问题概述

事故时间:2024-XX-XX 02:00(事故触发时间)

发现时间:2024-XX-XX 08:00(业务团队反馈订单处理异常)

事故类型:生产环境数据库误操作导致数据丢失

受影响数据类型:客户订单数据、财务记录(含部分交易流水)

业务影响:核心订单处理系统停滞12小时,涉及超过XX笔订单无法正常流转,直接导致客户服务延迟及潜在财务损失。

二、影响分析

- 直接业务影响

- 订单处理停滞:因数据库表被误删除,系统无法读取订单数据,导致业务中断12小时,客户投诉量激增(约XX例)。

- 财务损失:延迟订单需人工干预处理,额外消耗人力资源成本约XX小时;部分订单因延迟交付需补偿客户,预估损失金额XX元。

- 数据完整性风险:尽管99%的数据通过备份恢复,但仍有1%的数据(约XX条记录)因备份时间差需手动补录,存在潜在误差风险。

- 系统性风险

- 权限管控漏洞:涉事账号拥有生产环境高危操作权限(如直接执行

DROP TABLE命令),未遵循最小权限原则。 - 流程缺失:无操作审批流程,未对高风险操作进行事前审核及记录。

- 权限管控漏洞:涉事账号拥有生产环境高危操作权限(如直接执行

三、根本原因分析

- 直接原因

运维人员在执行例行维护时,因操作界面切换失误,误将测试环境脚本(含DROP TABLE命令)在生产环境执行,导致核心订单表被删除。 - 深层原因

- 权限管理不足:生产环境数据库账号未按角色分级,部分账号拥有高危操作权限且未配置操作审计。

- 缺乏审批流程:数据库变更操作未强制要求提交工单或上级审批,依赖人工自觉性。

- 环境隔离缺失:测试环境与生产环境脚本未严格隔离,操作界面易混淆。

四、解决方案与改进计划

- 紧急修复措施

- 已通过备份系统(备份时间点:2024-XX-XX 02:00)完成数据恢复,耗时3小时,恢复后数据完整性验证通过率99%,剩余1%数据由业务部门补录。

- 临时限制生产环境高危命令权限,仅保留DBA团队紧急访问通道。

- 长期改进措施

- 权限管控优化(2024-XX-XX前完成)

- 实施数据库账号权限分级制度,禁止非DBA账号执行

DROP、TRUNCATE等高危命令。 - 启用操作审计日志,记录所有敏感操作并关联责任人。

- 实施数据库账号权限分级制度,禁止非DBA账号执行

- 审批流程制度化(2024-XX-XX前完成)

- 上线数据库操作审批工单系统,强制要求变更操作需提交工单并经二级审批(申请人→直属主管→DBA团队)。

- 技术防护增强(2024-XX-XX前完成)

- 增加「高危操作二次确认」弹窗机制,强制输入操作原因及工单编号后方可执行。

- 实现测试环境与生产环境的物理隔离,避免脚本误执行。

- 人员培训与演练(每季度一次)

- 开展数据库操作规范及容灾恢复培训,模拟误操作场景进行应急演练。

- 权限管控优化(2024-XX-XX前完成)

五、经验总结

本次事故暴露了生产环境权限管控与流程规范的严重漏洞。后续将重点推进运维流程自动化与权限最小化原则,同时通过技术手段(如审批系统、操作拦截)降低人为失误风险,确保类似事件零复发。

报告提交人:XXX

日期:2024-XX-XX

附件:

- 数据恢复验证报告

- 权限分级制度草案

- 审批工单系统上线计划

模板4:网络故障事故报告

一、问题概述

事故类型:DDoS攻击(UDP洪水攻击)导致网络中断及延迟激增

影响设备:核心交换机、防火墙

发生时间:202X年XX月XX日 14:00-16:00(持续2小时)

根本原因:恶意攻击者通过UDP洪水攻击,导致核心交换机及防火墙负载激增,网络带宽被耗尽,正常业务流量被阻塞。

二、影响分析

- 业务影响:

- 网络中断:内部系统(如OA、邮件、数据库)无法访问,外部用户服务中断。

- 延迟激增:在线业务响应时间从平均50ms飙升至2000ms以上,用户体验严重受损。

- 经济损失:直接业务中断导致约XX万元收入损失,间接影响客户信任度。

- 设备影响:

- 核心交换机CPU利用率达98%,防火墙会话表项超限,触发自动保护机制阻断部分流量。

三、诊断过程

- 第一阶段:物理连接排查

- 检查核心交换机与防火墙的光纤、网线连接,确认无松动或物理损坏。

- 验证设备供电及散热正常,排除硬件故障可能性。

- 第二阶段:流量日志分析

- 通过防火墙流量监控发现异常:

- UDP协议流量占比90%,源IP分散且无业务关联。

- 攻击峰值流量达5Gbps,远超日常基线(500Mbps)。

- 结合NetFlow数据,确认攻击源IP分布在全球多个地区,属于典型DDoS攻击特征。

- 通过防火墙流量监控发现异常:

四、解决方案

1. 临时处置措施

- 启用备用带宽:通过多链路负载均衡策略,将部分流量切换至备用线路,缓解核心交换机压力。

- 封禁攻击IP:在防火墙上动态封禁攻击源IP段,阻断80%异常流量。

- 手动限速:对UDP协议流量实施临时限速策略,优先保障TCP业务流量。

2. 长期改进方案

- 部署云清洗服务:与第三方安全厂商合作,将流量牵引至云端清洗中心,过滤恶意流量后再回源。

- 升级防火墙规则库:更新至最新版本,启用基于AI的异常流量检测功能。

- 建立流量基线监控:部署实时流量分析系统,设定阈值告警,实现攻击早期预警。

五、经验总结

- 防御短板:现有防火墙规则库版本滞后,未能识别新型攻击特征。

- 响应时效:缺乏自动化攻击处置流程,依赖人工干预导致恢复时间延长。

- 改进计划:

- 定期演练应急预案:每季度模拟DDoS攻击场景,测试备用链路切换及封禁策略有效性。

- 完善监控体系:增加对核心设备CPU、会话数等关键指标的实时监控。

- 员工培训:针对运维团队开展DDoS攻防技术培训,提升应急响应能力。

报告提交人:XXX

审核人:XXX

日期:202X年XX月XX日

模板5:硬件故障事故报告

一、问题概述

设备类型:服务器(存储阵列相关)

故障部件:硬盘(序列号:XXXXXX)

故障现象:系统宕机,同时伴随IO性能显著下降。

事件时间线:

- 故障发生:设备在运行中宕机,系统日志显示硬盘(SN: XX)出现物理故障,导致RAID5阵列降级。

- 问题定位:运维团队通过硬件健康检查工具发现该硬盘的S.M.A.R.T.状态异常(坏道激增),且硬盘运行时长已超过5年(超过MTBF标称值)。

二、影响分析

- 业务影响:

- 服务中断:核心业务系统宕机约2小时,导致部分线上服务不可用。

- 数据风险:RAID 5阵列因单盘失效进入降级状态,存在潜在数据丢失风险。

- 技术影响:

- 存储性能:IO吞吐量下降至正常值的30%,影响关联业务系统的响应效率。

- 重建耗时:RAID 5阵列重建耗时4小时,期间系统处于高负载状态。

三、处理流程

- 备件更换:

- 使用同型号硬盘(SN: XXXXXX)替换故障盘,完成物理层修复。

- 数据恢复:

- 启动RAID 5阵列重建流程,成功恢复数据完整性,未发生数据丢失。

- 系统验证:

- 通过压力测试验证存储性能恢复正常,确认业务系统恢复可用性。

四、根本原因分析

- 直接原因:

- 硬件老化:故障硬盘已连续运行超过5年,超出厂商标称的平均无故障时间(MTBF)。

- 间接原因:

- 监控缺失:未配置硬盘S.M.A.R.T.状态告警,导致未能提前预警潜在故障。

- 生命周期管理漏洞:硬件更换策略未严格执行,超期设备未及时淘汰。

五、解决方案与预防措施

- 短期措施:

- 对所有同类存储阵列进行健康巡检,排查超期服役硬盘并优先更换。

- 启用S.M.A.R.T.监控告警,设置阈值自动触发工单。

- 长期措施:

- 更新硬件生命周期管理策略:

- 强制淘汰运行超过MTBF期限的设备。

- 建立备件库存动态管理机制,确保关键部件冗余。

- 定期生成硬件健康报告:

- 每月输出存储设备健康状态报告,包含硬盘寿命预测、RAID健康度等指标。

- 运维流程优化:

- 将RAID重建纳入应急预案,缩短恢复时间(RTO)。

- 更新硬件生命周期管理策略:

六、后续行动计划

| 任务 | 负责人 | 截止日期 | 状态 |

|---|---|---|---|

| 硬件生命周期策略更新 | IT运维部 | [填写日期] | 进行中 |

| 监控系统告警配置 | 运维工程师 | [填写日期] | 已完成 |

| 首次硬件健康报告生成 | 数据分析组 | [填写日期] | 待启动 |

| 超期硬盘更换 | 硬件团队 | [填写日期] | 规划中 |

七、总结

本次事故暴露了硬件老化监控及生命周期管理的不足。通过优化监控策略、强化预防性维护机制,可显著降低类似故障的发生概率。后续将重点落实硬件健康报告的常态化管理,并定期复盘运维流程的合规性。

报告提交人:[填写姓名/职位]

审核确认:[相关部门负责人签字]

想快速生成专业规范的IT事故报告?

免费试试我们的AI工具!输入大概信息即可一键生成,省时省力!→ IT事故报告生成📄

VM技术助理

VM技术助理